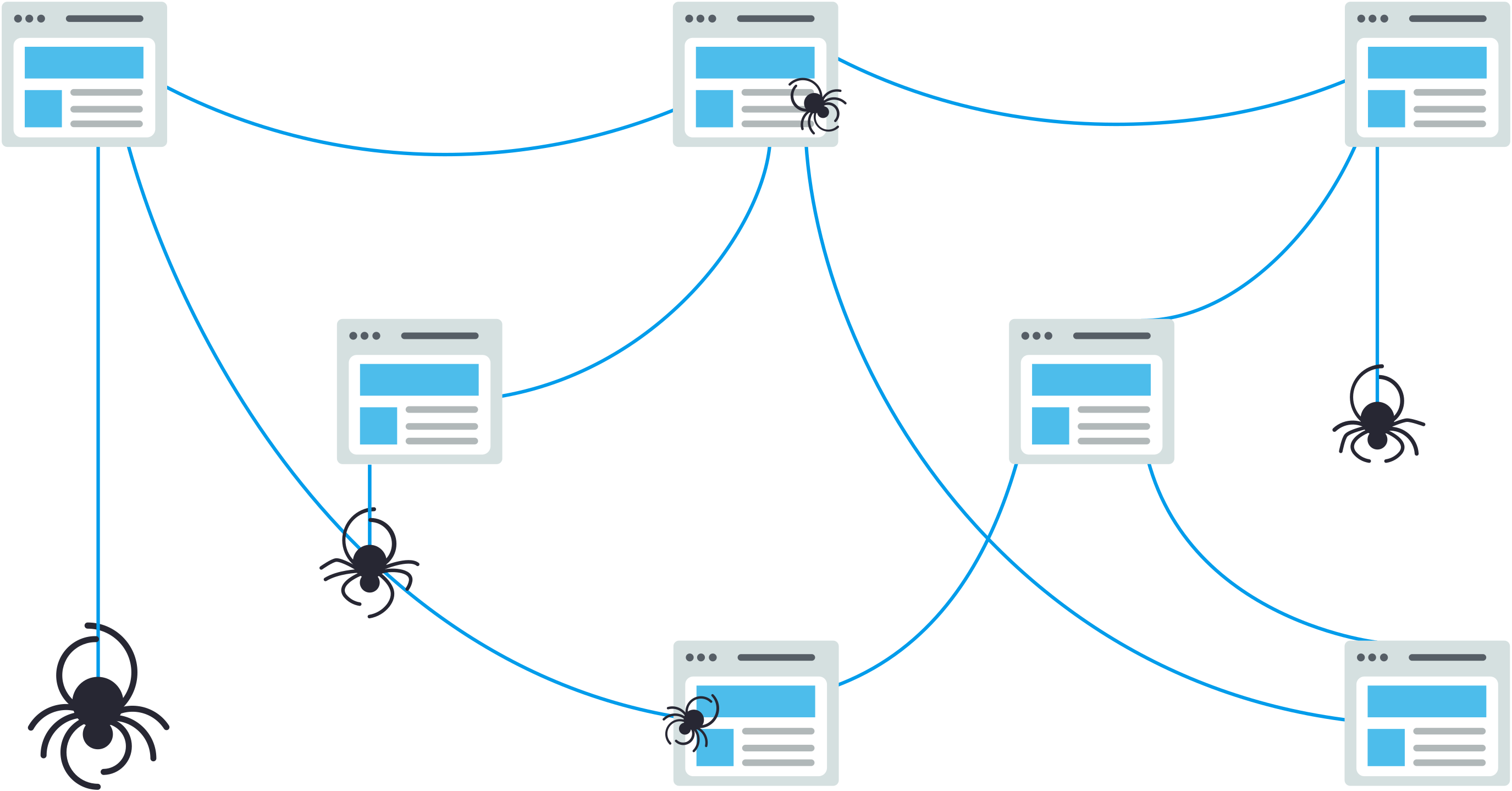

搜索引擎优化最容易忽视的重要元素就是如何让“爬虫”更好的发现并理解你的网站。这个过程被称为爬取和索引,它对于你的网站在搜索结果中的可见性至关重要。如果页面没有被爬取,它们就无法被索引,而如果没有被索引,它们就不会在搜索结果中显示或排名。

本文将讨论 13 个提高网站被“爬虫”爬取与索引的实用步骤,通过实施这些策略,你可以帮助像 Google 这样的搜索引擎更好地导航和分类你的网站,从而可能提升搜索排名和可见性。

通过以下这些实用步骤,提升你的网站爬取性和索引性,进而提高搜索排名和可见性。

1. 提高网页加载速度

页面加载速度对用户体验和搜索引擎的爬取性至关重要。要提高页面速度,可以考虑以下措施:

- 升级你的主机计划或服务器,确保最佳性能;

- 精简 CSS、JavaScript 和 HTML 文件,减少文件大小,提高加载速度;

- 通过压缩图片并使用合适的格式(如照片使用 JPEG,透明图形使用 PNG)来优化图片;

- 利用浏览器缓存,在用户设备上本地存储经常访问的资源;

- 减少重定向的数量,并消除任何不必要的重定向;

- 移除任何不必要的第三方脚本或插件。

这些措施有助于改善网站访客的体验和搜索引擎的爬取速度。

2. 优化核心网页指标 (Core Web Vitals)

除了常规的优化页面速度,提升 Core Web Vitals(核心网页指标)评分也至关重要。

Core Web Vitals 是 Google 认为对网页用户体验至关重要的几个具体因素。这些因素包括:

- 最大内容绘制时间 (LCP):衡量加载性能,应该在页面开始加载后 2.5 秒内完成;

- 下一个绘制的交互时间 (INP):衡量响应时间,尽量保持在 200 毫秒以下,来提供良好的用户体验;

- 累积布局偏移 (CLS):衡量视觉稳定性,CLS 分数应小于 0.1。

要识别与 Core Web Vitals 相关的问题,可以使用 Google 搜索控制台 (Google Search Console) 的 Core Web Vitals 报告、Google PageSpeed Insights 或 Lighthouse 等工具。这些工具会提供详细的页面性能分析,并提出改进建议。

优化 Core Web Vitals 的一些方法包括:

- 通过减少 JavaScript 执行时间来最小化主线程工作量;

- 通过为媒体元素设置尺寸属性和预加载字体来避免显著的布局偏移;

- 通过优化服务器、将用户路由到附近的 CDN 位置或缓存内容来改善服务器响应时间。

通过优化页面速度和 Core Web Vitals,可以让用户体验更快、更友好,同时能让搜索引擎爬虫更快速浏览和索引你的网站。

3. 优化爬取预算

爬取预算是指 Google 会在特定时间爬取你网站的页面数量。这个预算由你网站的规模、健康状况和受欢迎程度等因素决定。

如果你的网站有很多页面,就需要确保 Google 能够爬取和索引最重要的页面。以下是一些优化爬取预算的方法:

- 定期更新并重新提交你的 XML 网站地图,确保 Google 有最新的页面列表;

- 使用清晰的层级结构,确保你的网站结构简洁易导航;

- 识别并消除重复内容,以避免浪费爬取预算在重复页面上;

- 使用 robots.txt 文件阻止 Google 爬取不重要的页面,如测试环境或管理页面;

- 实施规范化,将多个版本页面 (例如带有和不带查询参数的页面) 的信号整合到一个规范的 URL 中;

- 在 Google 搜索控制台 (Google Search Console) 中监控你网站的爬取统计数据,识别任何异常的爬取活动高峰或下降 (这可能表明你网站的健康状况或结构存在问题)。

4. 加强内部连接结构

拥有良好的网站结构和内部链接是成功 SEO 策略的关键。一个结构混乱的网站会让搜索引擎难以爬取,因此内部链接是网站可以做的最重要的事情之一。如果内部链接做得不好,可能会导致孤立页面或没有链接到其他部分的页面。由于没有链接指向这些页面,搜索引擎只能通过你的网站地图找到它们。所以,为了解决这个问题以及由糟糕结构引起的其他问题,创建一个逻辑清晰的内部结构是必要的。

- 首先,你的主页应该链接到子页面,这些子页面再通过自然的上下文链接到更深入的页面;

- 还要注意检查坏链接,包括那些 URL 中有错别字的链接。这些链接会导致“404错误”(页面未找到),这对网站的爬取有害无益;

- 在进行网站迁移、大量删除或结构更改后,务必仔细检查 URL,确保没有链接到旧的或已删除的 URL 中;

- 其他内部链接的最佳实践包括使用锚文本而不是链接图片,并在每个页面上添加适量的链接 (添加过多的链接也可能变得负面,所以还是要适量);

- 另外,确保你使用的是“follow”链接来进行内部链接。

5. 向 Google 提交站点地图

Google 会自动爬取你的网站,但需要一些时间,在等待的过程中,你的网站排名不会立即提高。

在这之前如果你最近对网站内容进行了更改,并且希望 Google 尽快知道这些变化,你可以通过 Google 搜索控制台 (Google Search Console) 提交一个站点地图 (是一个存放在你网站根目录中的文件,它就像一张地图,向搜索引擎展示你网站上所有页面的链接)。

提交站点地图的好处在于,Google 可以一次性发现你网站上的所有页面,而不需要通过多个内部链接去逐步找到它们。例如,如果一个页面很深层,爬虫可能需要点击好几次才能找到,但通过提交站点地图,Google 可以直接找到所有页面。

如果你的网站结构复杂、经常增加新页面,或者内部链接做得不够好,向 Google 提交站点地图会非常有帮助。这样,Google 就可以更快、更全面地了解你的网站。

6. 更新 robots.txt 文件

你的网站需要一个 robots.txt 文件,这个文件是放在你网站根目录中的纯文本文件,用来告诉搜索引擎你希望它们如何爬取你的网站。它的主要作用是管理机器人流量,防止你的网站因过多的请求而过载。

在爬取性方面,robots.txt 文件可以限制 Google 爬取和索引哪些页面。例如,你不希望像目录、购物车和标签这样的页面出现在 Google 的索引中,就可以设置隐藏。不过,这个文件也可能对你的爬取性产生负面影响。因此,你需要了解你的 robots.txt 文件 (如果你懂这个,可以请懂行的人帮忙看看),确保你没有无意中阻止爬虫访问你的页面。

常见的 robots.txt 错误包括:

- 没有包含网站地图 URL

- robots.txt 文件不在根目录

- 不当使用通配符

- 在 robots.txt 中使用了 noindex

- 阻止了脚本、样式表和图片的访问

如需深入了解这些问题以及解决这些问题的技巧,请阅读本文。

7. 规范化标签

规范标签可以帮助 Google 识别主要页面并跳过重复内容,但错误的标签可能引发索引问题。导致“流氓”规范标签的出现,这些标签会指向已不存在的旧版本页面,导致搜索引擎索引错误的页面,而你希望被索引的页面却无法被找到。可以使用 URL 检查工具检查并移除错误标签,尤其是面向国际用户时,需要为每种语言设置规范标签,这可以让你的网站页面在每种语言下都被索引。

8. 进行网站审核

在完成其他步骤后,进行网站审查可以确保你的网站是否已被优化好。

检查网站页面的索引率

索引率是指 Google 已索引的页面数量与网站总页面数量的比率。

首先,需要检查 Google 已为你的网站索引了多少页面。你可以通过 Google 搜索控制台 (Google Search Console) 的“网页 (Pages)”选项查看 Google 索引了多少页面,并从内容管理系统(CMS)的管理面板查看你的网站总共有多少页面。

通常,网站上会有一些你不希望被索引的页面,所以索引率不太可能达到 100%。不过,如果索引率低于 90%,你可能需要进行进一步的检查。你可以从搜索控制台获取未被索引的 URL,并对这些页面进行审核,这有助于你了解问题的原因。

Google 搜索控制台 (Google Search Console) 还提供了一个有用的工具,即 URL 检查工具。这个工具可以让你查看 Google 爬虫看到的内容,然后你可以将其与实际网页进行比较,了解 Google 未能渲染的部分。

审核 (并请求索引) 新发布的页面

每当你发布新页面或更新最重要的页面时,你需要确保它们已被索引。进入 Google 搜索控制台 (GSC),使用检查工具确保这些页面都已显示出来。如果没有,请求索引该页面,通常在几小时到一天内生效。

如果仍有问题,审核还可以帮助你了解 SEO 策略的其他部分哪里不足,所以这是一个双赢的过程。你可以使用 Screaming Frog、Semrush、Ziptie、Oncrawl、Lumar 等工具来扩大你的审核过程。

9. 检查重复内容

重复内容是导致搜索引擎爬虫在你的网站上卡住的另一个原因。你的编码结构会让它感到困惑,不知道该索引哪个版本。这可能是由会话 ID、冗余内容元素和分页问题等引起的。

有时,这会在 Google 搜索控制台中触发警报,但如果你没有收到此类警报,可以检查爬取结果,看看是否有重复或缺失的标签,或者包含额外字符的 URL。这些都可能会为爬虫增加额外的工作量,你可以通过修复标签、移除页面或调整Google的访问权限来纠正这些问题。

10. 避免重定向链和重定向循环

随着网站的发展,重定向是自然而然的结果,它将访问者从一个页面引导到更新或更相关的页面。但尽管大多数网站都会使用重定向,但如果处理不当,你可能会无意中破坏页面的索引。

创建重定向时,常见的错误之一是重定向链。这种情况发生在点击的链接和目标页面之间有多个重定向。在更极端的情况下,可能会出现重定向循环,即一个页面重定向到另一个页面,再重定向到另一个页面,最终又回到第一个页面。换句话说,你创建了一个无尽的循环,无法到达任何地方。

可以使用 Screaming Frog、Redirect-Checker.org 或类似工具检查你网站的重定向。

11. 修复断开的链接

断开的链接也会严重影响你网站的可爬性。你应该定期检查网站,确保没有断开的链接,因为这会损害 SEO 效果,让访问用户无法点击查看网页。

你可以通过多种方式找到网站上的断开链接,包括手动检查网站上的每个链接 (如页眉、页脚、导航、文本内链接等),或者使用 Google 搜索控制台、分析工具或 Screaming Frog 查找 404 错误。找到断开的链接后,有 3 种修复方法 – 重定向它们 (请参阅上面的注意事项)、更新它们或删除它们。

12. IndexNow 协议

IndexNow 是一种协议,允许网站主动告知搜索引擎内容的变化,从而确保新内容、更新内容或已删除内容能够更快地被索引。

谨慎地使用 IndexNow,可以提高网站的可爬性和可索引性。而且仅在对网站价值有重大提升的内容更新时使用它非常重要。以下是一些显著变化的例子:

- 对于电商网站,产品可用性变化、新产品发布和价格更新;

- 对于新闻网站,发布新文章、发布更正和删除过时内容;

- 对于动态网站,包括在关键时刻更新财务数据、更改体育比赛比分和统计数据以及修改拍卖状态;

- 避免在短时间内过于频繁地提交重复的 URL,这会对信任度和排名产生负面影响;

- 确保在通知 IndexNow 之前,你的内容已经在网站上完全上线。

如果可能,将 IndexNow 集成到你的内容管理系统 (CMS) 中,以实现无缝更新。如果你手动处理 IndexNow 通知,请遵循最佳实践,通知搜索引擎有关新 / 更新内容和已删除内容的信息。

把 IndexNow 纳入你的内容更新策略,可以确保搜索引擎拥有你网站内容的最新版本,从而改善爬取性、索引性,并最终提高搜索可见性。

13. 实现结构化数据以增强内容理解

结构化数据是一种标准化格式,用于提供页面信息并对其内容进行分类。

通过在网站上添加结构化数据,你可以帮助搜索引擎更好地理解和上下文化你的内容,从而提高出现在丰富结果中的机会,增加搜索中的可见性。

有几种类型的结构化数据,包括:

- Schema.org:由 Google、Bing、Yandex 和 Yahoo! 共同创建的统一结构化数据标记词汇;

- JSON-LD:一种基于JavaScript 的格式,用于在网页的<head>或<body>中嵌入结构化数据;

- Microdata:一种 HTML 规范,用于在 HTML 内容中嵌套结构化数据。

要在网站上实现结构化数据,请遵循以下步骤:

- 识别页面上的内容类型(如文章、产品、活动)并选择适当的 schema;

- 使用 schema 的词汇标记你的内容,确保包含所有必需属性并遵循推荐格式;

- 使用 Google 的丰富结果测试或 Schema.org 的验证工具测试你的结构化数据,以确保其正确实现且无错误;

- 使用 Google 搜索控制台的丰富结果报告监控你的结构化数据性能。该报告显示你的网站有资格参与哪些丰富结果,以及实现过程中存在的任何问题。

一些常见的可以从结构化数据中受益的内容类型包括:

- 文章和博客文章

- 产品和评论

- 活动和票务信息

- 食谱和烹饪说明

- 个人和组织简介

通过实施结构化数据,你可以为搜索引擎提供更多关于内容的上下文,使其更容易准确地理解和索引你的页面。这可以通过丰富结果 (如特色片段、轮播和知识面板) 提高搜索结果的可见性。

结论

遵循以上 13 个步骤,持续优化你的网站你就能创建一个更适合搜索引擎的网站,从而提高在搜索结果中排名的机会。从基础如提高页面速度和优化网站结构,慢慢尝试再往更高级的技术一步步优化,搜索引擎会更容易发现、理解并索引你的内容。对于需要改进的地方,不要气馁,每一步改善网站的可爬行性和可索引性,都是朝着更好搜索表现迈出的步伐。积少成多!

猜你可能喜欢

- Google 认证的 3 种让 Googlebot 快速抓取更多内容的方法

- 8 个常见的 robots.txt 问题及修复方法

- Google 推出了 2024 年 8 月的核心更新

- Google 计划为 Gemini 添加“深度研究”功能

TopsTip

TopsTip

评论前必须登录!

立即登录 注册