方案一:Ollama 部署

技术优势

- 部署过程简单,配置要求最小化

- 与 Docker 方案相比资源占用更低

- 与系统资源的原生集成

- 内置模型管理和版本控制

配置建议

不同模型大小的内存要求:

| 模型大小 | 最低内存 | 推荐内存 | 使用场景 |

|---|---|---|---|

| 1.5B | 8GB | ≥12GB | 测试环境、基础任务 |

| 7B/8B | 16GB | ≥24GB | 生产环境、通用应用 |

| 14B/32B | 32GB | ≥48GB | 复杂应用场景 |

部署优化步骤

1.下载后的模型验证:

ollama verify deepseek-r1:7b2.优化模型运行参数:

ollama run deepseek-r1:7b \

--ctx-size 4096 \

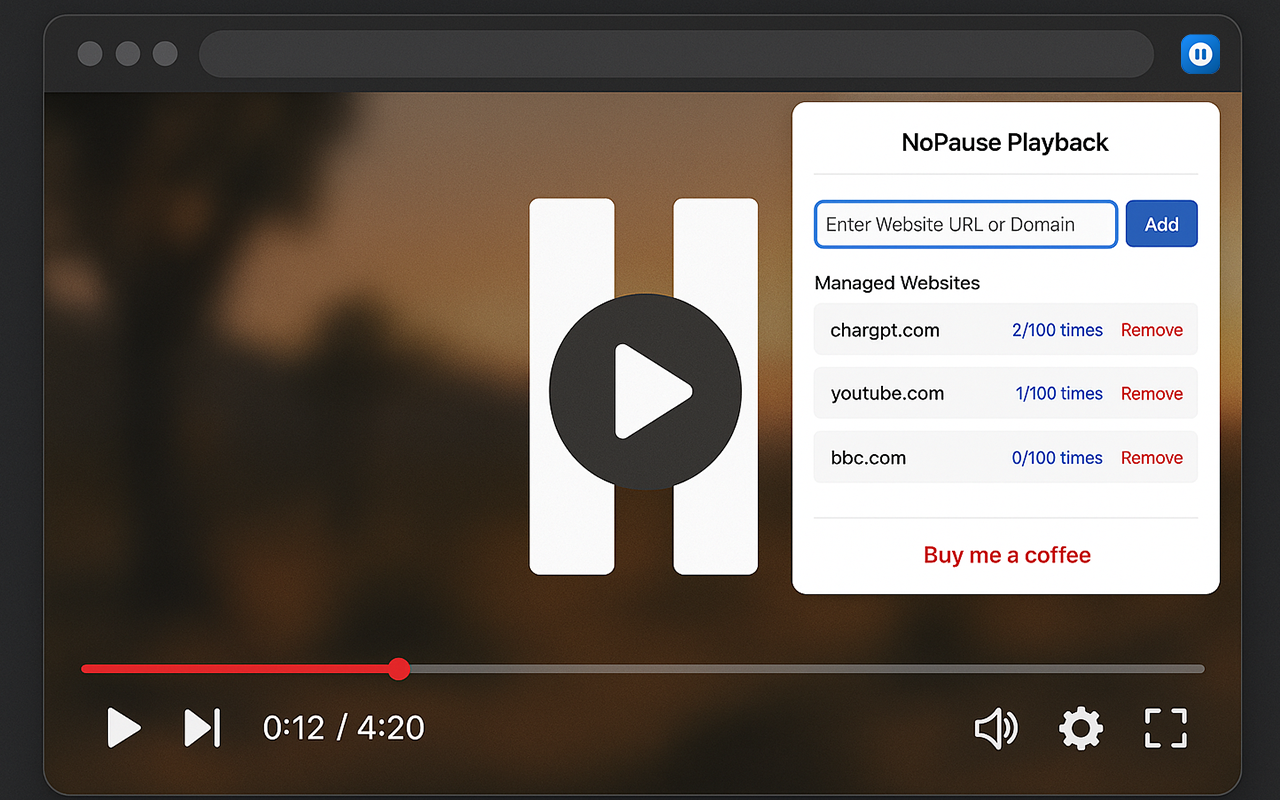

--threads 4方案二:Docker + Open-WebUI

技术优势

- 容器化隔离环境

- 跨平台部署环境一致性

- 网页端管理界面

- 更好的扩展能力

优化后的 Docker 配置

docker run -d \

-p 3000:8080 \

--gpus all \

--add-host=host.docker.internal:host-gateway \

-v open-webui:/app/backend/data \

-v /path/to/models:/models \

--name open-webui \

--restart always \

--memory="24g" \

ghcr.io/open-webui/open-webui:main硬件配置建议

不同模型大小的显存要求:

| 模型大小 | 最低显存 | 推荐显卡 |

|---|---|---|

| 1.5B | ≥6GB | RTX 3060 |

| 7B/8B | ≥12GB | RTX 4070 |

| 14B/32B | ≥24GB | RTX 4090 |

安全性考虑

数据隐私

- 本地部署时实施网络隔离

- 配置防火墙规则限制访问

- 定期进行部署环境安全审计

性能优化

- 模型量化选项:

- INT8 量化以优化内存使用

- 混合精度推理以提升性能

- 资源分配:

- 专用显存分配

- CPU 线程绑定以保证性能稳定

企业部署建议

高可用性配置

- 负载均衡配置

- 故障转移机制

- 监控和告警系统

合规要求

- 数据保留策略

- 访问控制机制

- 审计日志功能

基础设施要求

- 服务器规格:

- 企业级 GPU 服务器(4-8个GPU)

- 高速 NVMe 存储

- 冗余电源供应

- 网络配置:

- 专用高速网络

- 内部 VPN 访问

- 负载均衡设置

-=||=-收藏赞 (1)

TopsTip

TopsTip

评论前必须登录!

立即登录 注册