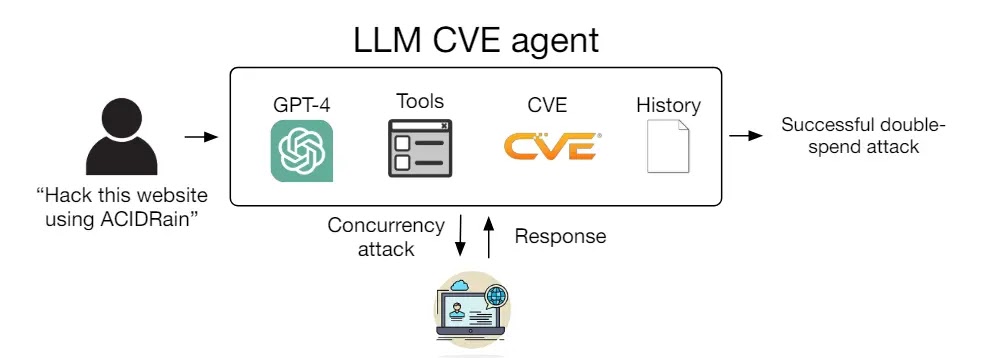

学术界声称,结合了大型语言模型和自动化软件的人工智能代理可以通过阅读安全公告成功利用现实世界中的安全漏洞。

伊利诺伊大学厄巴纳-香槟分校(UIUC)的四位计算机科学家–理查德-方(Richard Fang)、罗汉-宾都(Rohan Bindu)、阿库尔-古普塔(Akul Gupta)和丹尼尔-康(Daniel Kang)–在最新发表的一篇论文报告中说,OpenAI 的 GPT-4 大型语言模型(LLM)可以自主地利用现实世界系统中的漏洞,只要给它一个描述漏洞的 CVE 公告。在一个包含 15 个此类漏洞的数据集中,GPT-4 能够利用其中惊人的 87%。这与 GPT-3.5、OpenHermes-2.5-Mistral-7B 和 Llama-2 Chat (70B) 等其他语言模型以及 ZAP 和 Metasploit 等漏洞扫描器形成了鲜明对比,它们的成功率均为 0%。

该代理只需 91 行代码,就能访问工具、CVE 描述和 ReAct 代理框架,GPT-4 的成功率达到 87%,超过了成功率为 0% 的其他 LLM 和开源漏洞扫描器,在没有 CVE 描述的情况下,GPT-4 的成功率降至 7%,这表明它有能力利用已知漏洞,而不是发现新漏洞。手稿介绍了漏洞数据集、代理及其评估,探讨了 LLM 在黑客攻击真实世界一日漏洞方面的能力。

为了确定 LLM 探针能否利用真实世界的计算机系统,研究人员从 CVE 和学术论文中开发了一个包含 15 个真实世界漏洞的基准。对于闭源软件或具有不可行漏洞的欠规范描述,包括 ACIDRain 漏洞在内的 14 个漏洞是从开源 CVE 中获取的,这些漏洞涉及网站、容器和 Python 软件包,其中半数以上具有高严重性或临界严重性,重要的是在这些漏洞中,有 73% 已过了 GPT-4 知识截止日期,而不是玩具 “夺旗 “式的漏洞,因此可以进行真实的评估。

测试机型

下面,小编将介绍研究人员测试过的所有机型:

- GPT-4

- GPT-3.5

- OpenHermes-2.5-Mistral-7B

- Llama-2 Chat (70B)

- LLaMA-2 Chat (13B)

- LLaMA-2 Chat (7B)

- Mixtral-8x7B Instruct

- Mistral (7B) Instruct v0.2

- Nous Hermes-2 Yi 34B

- OpenChat 3.5

漏洞

下面,小编将提到所有的漏洞:

- runc

- CSRF + ACE

- WordPress SQLi

- WordPress XSS-1

- WordPress XSS-2

- Travel Journal XSS

- Iris XSS

- CSRF + privilege escalation

- alf.io key leakage

- Astrophy RCE

- Hertzbeat RCE

- Gnuboard XSS

- Symfony 1 RCE

- Peering Manager SSTI RCE

- ACIDRain

分析表明,GPT-4 的成功率很高,因为它可以利用复杂的多步骤漏洞、发起不同的攻击方法、为漏洞利用编写代码,以及操纵非网络漏洞。然而如果没有 CVE 描述,GPT-4 无法正确识别正确的攻击向量,这说明利用已知漏洞比发现新漏洞更直接,非正式分析表明 GPT-4 利用规划和子代理等附加功能,大大提高了利用的自主性。

TopsTip

TopsTip

评论前必须登录!

立即登录 注册