虽然有 LM Studio 和 GPT4All 这样的应用程序可以在电脑上本地运行人工智能模型,但在安卓手机上却没有太多这样的选择。不过 MLC LLM 开发了一款名为 “MLC Chat”的安卓 App,让你可以在安卓设备上下载并本地运行 LLM 模型,你可以下载小型人工智能模型(2B 到 8B),如 Llama 3、Gemma、Phi-2、Mistral 等。

快速概览

- 通过 MLC Chat 应用程序,你可以在本地安卓设备上下载并运行人工智能模型;

- 它提供多种人工智能模型,如 Gemma 2B、Phi-2 2B、Mistral 7B,甚至最新的 Llama 3 8B 模型;

- 你可能会在最新的骁龙手机上获得良好的性能,但在旧设备上,token 生成速度接近每秒 3 个 token;

⚠️请注意:

目前,MLC Chat 并未在所有骁龙设备上使用设备上的 NPU,因此 token 生成速度很慢,推理仅由 CPU 完成。但有些设备如三星 Galaxy S23 Ultra(搭载骁龙 8 代 2)已经过优化,可以运行 MLC Chat 应用程序,因此你可能会有更好的体验。

接下来是操作步骤,我们开始吧!

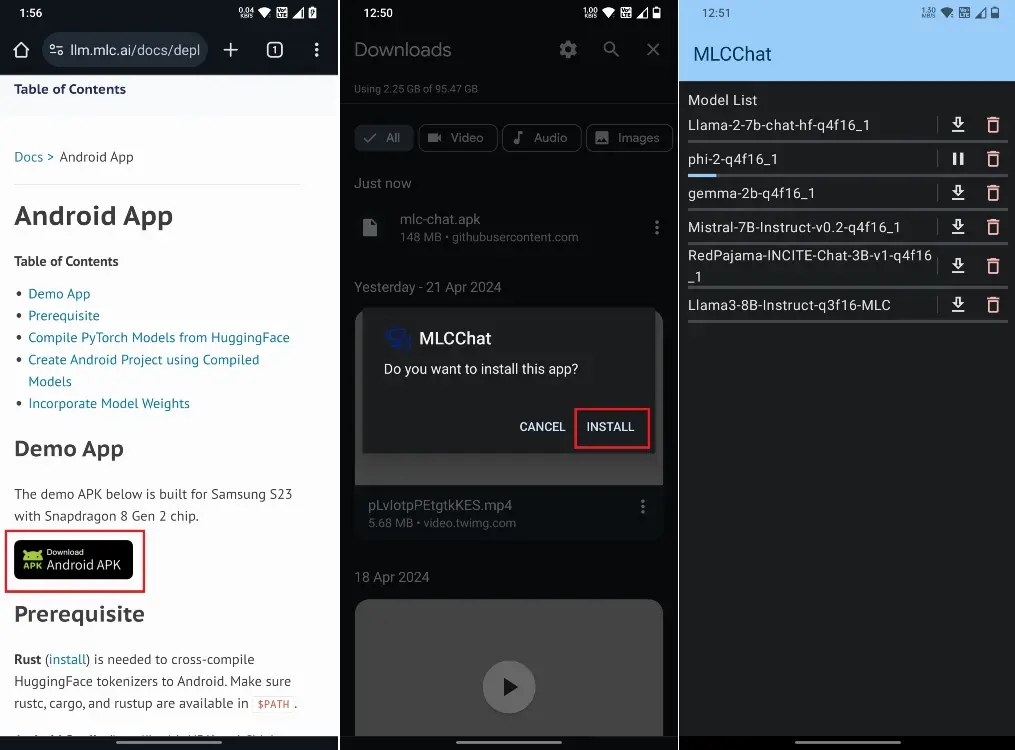

1. 下载安卓手机的 MLC Chat 应用程序(免费),需要你下载 APK 文件(148MB)并安装;

2. 接下来,启动 MLC Chat 应用程序,你将看到 AI 型号列表,它甚至支持最新的 Llama 3 8B 型号,你还可以选择 Phi-2、Gemma 2B 和 Mistral 7B;

3. 小编下载了微软的 Phi-2 模型,因为它小巧轻便;

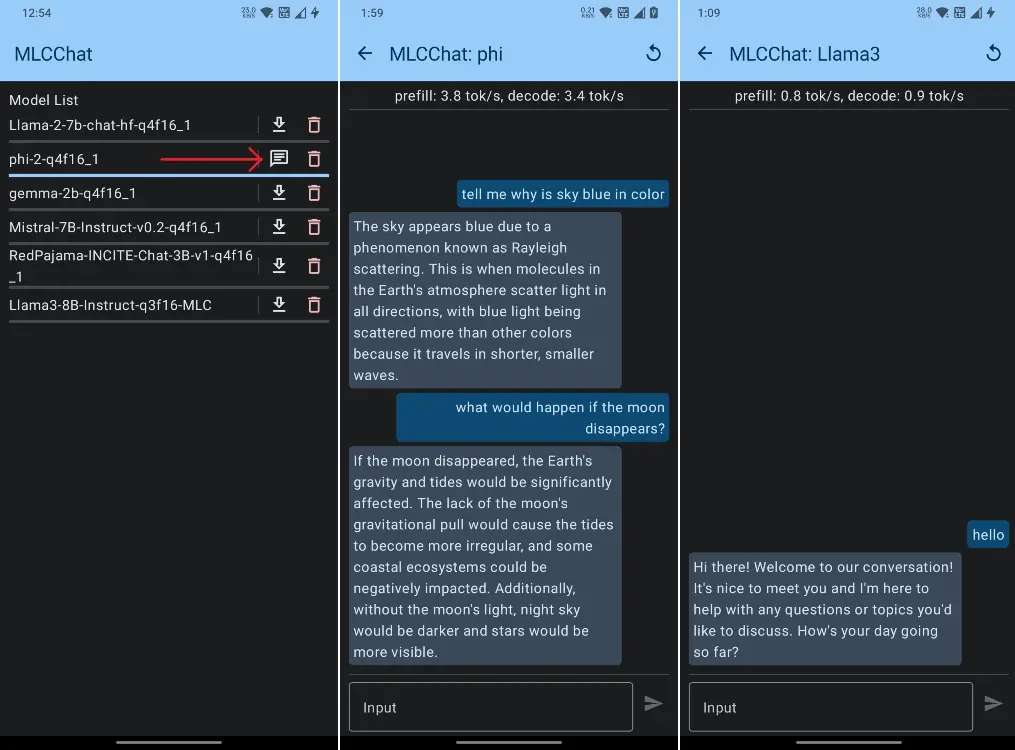

4. 下载模型后,点击模型旁边的聊天按钮;

5. 现在,你就可以在安卓手机上开始与本地的人工智能模型聊天了,你甚至不需要互联网连接;

6. 在小编的测试中,Phi-2 能在手机上运行正常,但出现了一些错误,Gemma 拒绝运行,而 Llama 3 8B 运行速度太慢;

7. 小编的 OnePlus 7T 搭载的是骁龙 855+ SoC(一款 5 年前的芯片),在运行 Phi-2 时,它以每秒 3 个 token 的速度产生输出。

这就是在安卓设备上下载并本地运行 LLM 模型的方法。当然 token 生成速度很慢,但它能使用,这表明,现在你可以在安卓手机上本地运行人工智能模型了。虽然目前它只能使用 CPU,但有了高通 AI Stack 的实现,基于 Snapdragon 的 Android 终端可以利用专用的 NPU、GPU 和 CPU 来提供更好的性能。

TopsTip

TopsTip

评论前必须登录!

立即登录 注册