2025年11月17日,ElevenLabs 正式推出 Image & Video(Beta)功能,这家以超自然AI语音合成闻名的独角兽公司,终于把触手伸向了视觉生成领域。简单来说,它把目前最顶尖的图像/视频模型(Google Veo 3系列、OpenAI Sora 2、Kling 2.5、Flux Kontext、Nanobanana、Seedream、Wan、Seedance 等)全部塞进自家平台,再无缝对接 ElevenLabs 引以为傲的语音、音乐、音效和唇同步工具,试图打造一个“一站式”AI内容工厂——从文本/图片起手,到完整带声视频输出,全程不用跳出窗口。

核心亮点:真正的多模态闭环 过去我们做短视频或营销素材,通常要在 Runway/Kling/Pika 生成视频 → Midjourney/Flux 补图 → ElevenLabs 加旁白 → CapCut/DaVinci 剪辑合唇同步。现在 ElevenLabs 把这些步骤强行拉到一个 workspace 里:

- 生成视频/图像后,直接拖进 Studio 项目;

- 一键添加 ElevenLabs 最强的语音(支持情感、语气标签)、AI音乐、环境音效;

- 自动唇同步 + 字幕 + 背景音乐混音;

- 最后直接导出商用级 MP4。

对营销人员、YouTuber、自媒体和小型广告团队来说,这确实省了大量切换软件的时间。测试中,我用 Veo 3.1 生成一段“赛博朋克城市夜景无人机航拍”,再用 Kling 2.5 补一个人物特写,合在一起不到2分钟,然后直接套上 ElevenLabs 新款情感语音旁白 + 自研 AI 配乐,整条视频从提示词到成品不到10分钟,唇同步几乎完美,声音细节(呼吸、停顿、情绪起伏)依然是行业天花板。

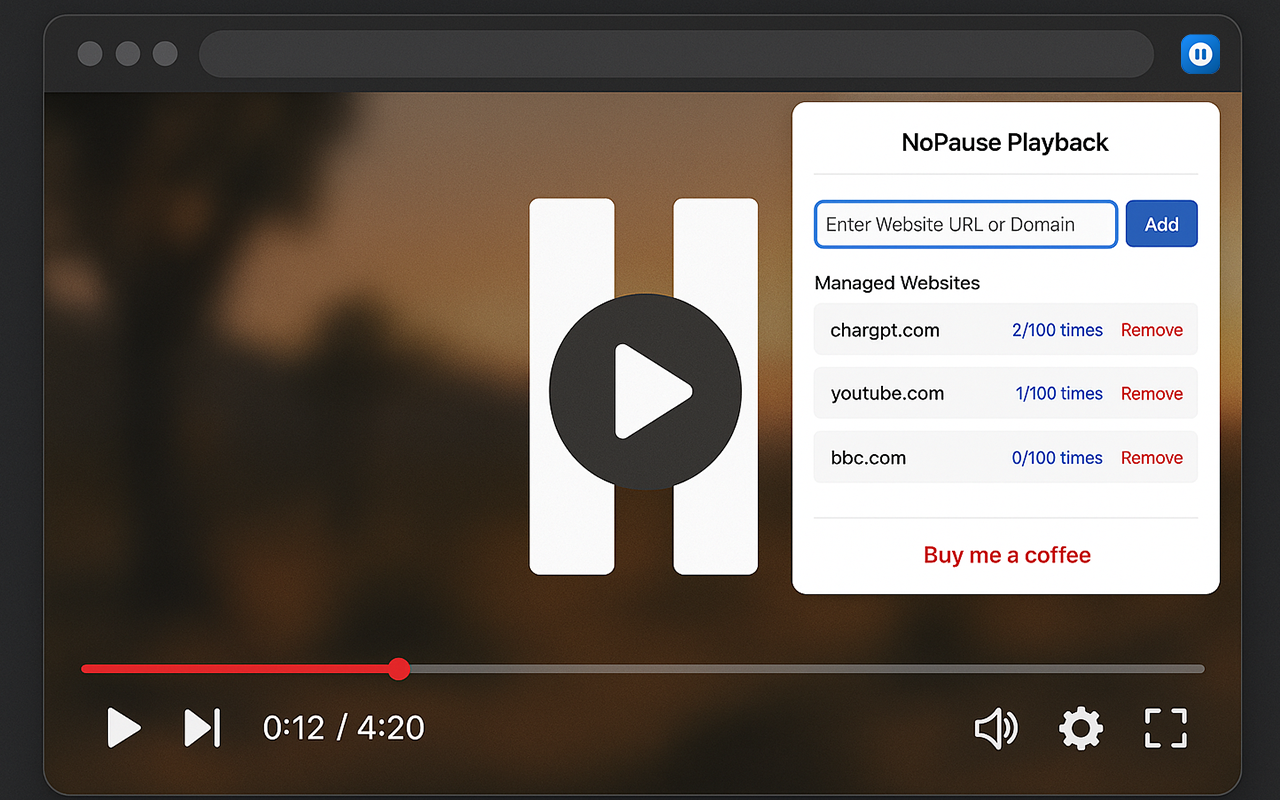

模型实力:不自己造轮子,但选品极狠 ElevenLabs 很聪明,没有像 Runway 那样all in自研视频模型,而是直接代理了当前最强的几家:

- Veo 3.1:运动一致性、物理模拟最强,适合写实长镜头;

- Sora 2 Pro:画面美学和提示词理解依然领先;

- Kling 2.5:人物动作和相机运动最自然;

- Flux Kontext / Nanobanana / Seedream:图像细节和风格控制极强,可当 storyboard 用。

实测下来,单个模型的表现和原生平台几乎无差别,延迟略高(多了一层代理),但能接受。最爽的是你可以同一提示词横向对比不同模型,一键切换,极大降低了“赌模型”的心理成本。

痛点与不足(Beta 阶段正常现象)

- 价格尚未完全公开:免费额度只允许生成图像,视频生成明显要走付费模型,且不同模型消耗的 credits 差异巨大(Sora 2 Pro 最贵,Veo Fast 最便宜)。对重度用户来说,最终成本可能不比单独订阅多个平台低。

- 视频时长与分辨率限制:目前最长20秒左右(取决于模型),1080p 上限,4K 还得等后续。想做30秒+广告还得拆条拼接。

- 创意控制仍需迭代:虽然支持起始帧/参考图,但高级功能如 Veo 的“相机控制”或 Kling 的“运动刷子”还没完全暴露,精细剪辑还是得导出后去专业软件。

- 一致性问题:跨模型拼接时,风格统一仍需手动调提示词,不如完全自研的一体化体验。

总结:2025年最值得关注的“生产力杀手”之一 如果你已经是 ElevenLabs 的语音重度用户(尤其是营销、播客、教育内容创作者),这个 Image & Video 功能几乎是“免费午餐”级别的升级,直接把你的生产效率拉高一个量级。它不是要取代 Kling 或 Pika,而是要把“视觉 + 音频”这个最常见的内容组合彻底一体化。

对纯视频创作者来说,它目前还不能完全替代专用视频平台,但对需要大量“带解说”的短视频、广告、社媒内容的生产者而言,这可能是2025年最香的工具没有之一。强烈建议大家去官网抢先体验 Beta——当你第一次在 ElevenLabs 里完成一条从零到一、带完美旁白的商业视频时,那种“原来可以这么简单”的震撼感,真的会上瘾。

TopsTip

TopsTip

评论前必须登录!

立即登录 注册